谁将成为开放模型最强王者?

谷歌发布 Gemma 开放模型

在推出最新版 Gemini 型号不到一周后,当地时间 2 月 21 日,谷歌再次公布 Gemma 项目——一个新的轻量化开放权重模型家族,自即日起已开始面向全球开放,可用于商业和研究用途。据悉,Gemma 由 Google DeepMind 及谷歌旗下其他团队开发而成,采用与 Gemini 模型相同的研究与创建技术,并因拉丁语的 gemma“宝石”一词而得名。

谷歌表示,经过预训练及指令微调的 Gemma 模型能够在用户的笔记本电脑、工作站或者 Google Cloud 上运行,并可被轻松部署在 Vertex AI 及 Google Kubernetes Engine(GKE)之上。谷歌称,希望 Gemma 能希望帮助开发人员和研究群体以负责任的方式构建 AI 方案。

本次谷歌共发布两种模型权重版本:Gemma 2B 与 Gemma 7B,每个版本都将公开经过预训练与指令微调的变体。除了模型权重之外,谷歌还发布了用于支持开发者创新、促进协作并指导受众以负责任方式使用 Gemma 模型的更多配套工具。比如新的 Responsible Generative AI Toolkit(负责任生成式 AI 套件)将为使用 Gemma 创建安全 AI 应用提供引导与基础工具。此外,谷歌还通过原生 Keras 3.0 提供跨越各主要框架的推理与监督微调(SFT)工具链,包括 JAX、PyTorch 及 TensorFlow 等。

除了即开即用的 Colab 和 Kaggle notebooks 以外,谷歌还将整合 Hugging Face、MaxText、英伟达 NeMo 以及 TensorRT-LLM 等流行工具,帮助用户轻松开始使用 Gemma。

用户可以利用自己的数据对 Gemma 模型进行微调,从而适应特定应用场景需求,例如摘要或检索增强生成(RAG)。此外,Gemma 还支持多种工具和系统:

多框架工具:用户可以随意挑选自己最喜爱的框架,并跨越多框架 Keras 3.0、原生 PyTorch、JAX 以及 Hugging Face Transformers 等建立推理与微调的参考实现。

跨设备兼容:Gemma 模型能够跨越多种流行设备实现运行,包括笔记本电脑、台式机、物联网、移动设备和云,从而实现 AI 功能的广泛可及。

顶尖硬件平台:谷歌与英伟达合作,针对英伟达 GPU 对 Gemma 做出优化,范围涵盖从数据中心到云端、再到本地 RTX AI PC,确保既保持行业领先的性能、又与顶尖硬件适配良好。

针对 Google Cloud 进行优化:Vertex AI 提供广泛的 MLOps 工具集,其中包含一系列微调选项以及包含内置推理优化的一键部署方案。全托管 Vertex AI 工具或自管理 GKE 还可提供高级自定义功能,包括立足任一平台跨越 GPU、TPU 和 CPU 部署起经济高效的 AI 基础设施。

谷歌:Gemma 是同等规模内性能最强模型

谷歌并未发布具体的说明文件,将这些模型与 Meta 和 Mistral 等厂商的同类模型做性能对比,而只是泛泛提到 Gemma 模型“行业领先”。目前唯一可以确定的,就是 Gemma 模型家族为密集纯解码器模型,与 Gemini 模型(以及更早的 PaLM 模型)拥有相同的技术和基础设施组件。

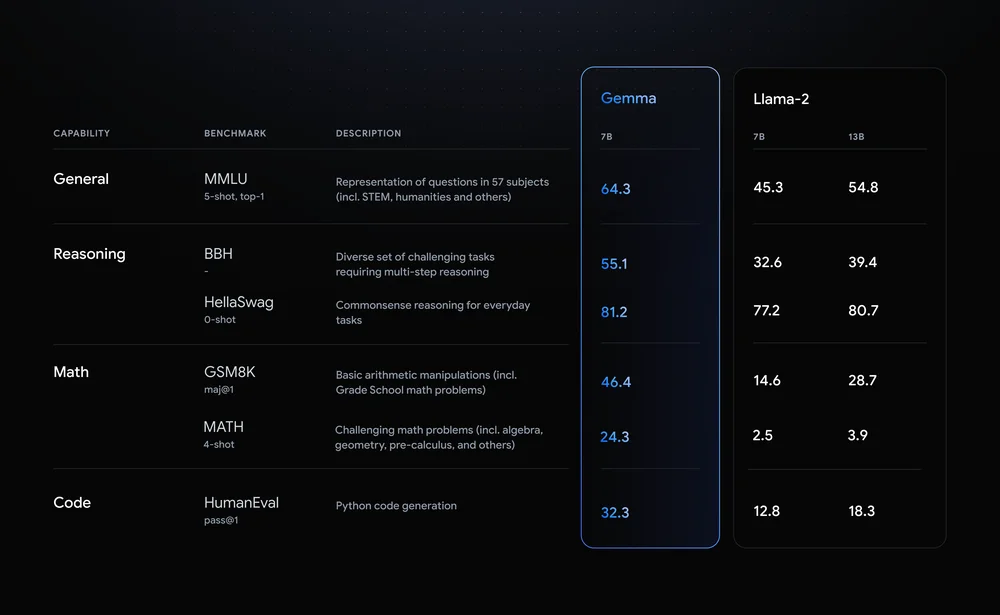

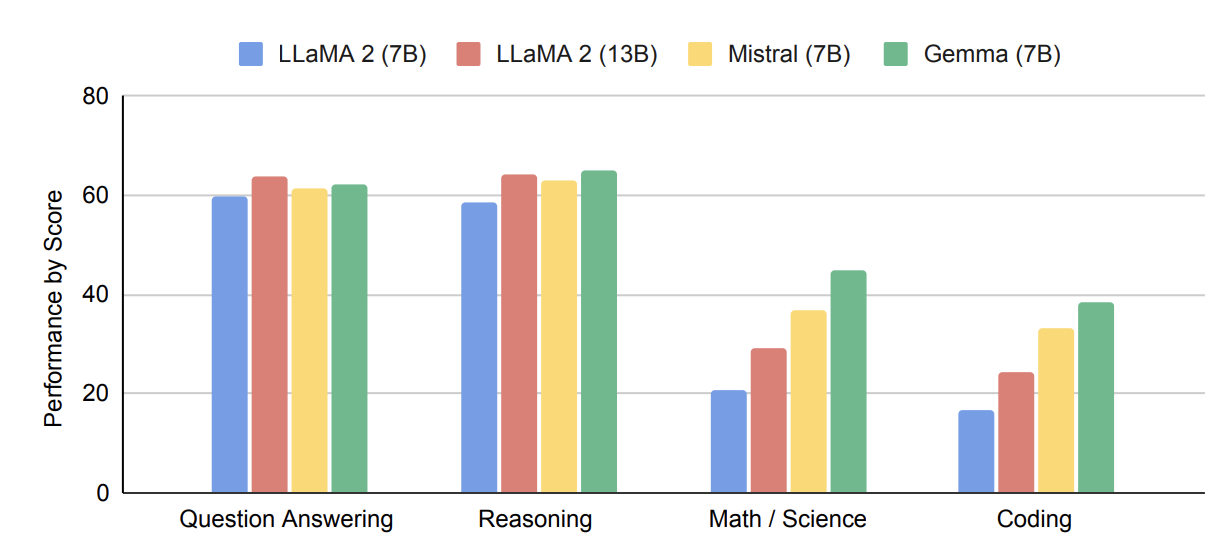

谷歌表示,与其他开放模型相比,Gemma 2B 与 7B 均在同等规模范围内拥有最出色的性能表现。Gemma 模型能够直接在开发人员的笔记本电脑或台式计算机上运行,而且值得注意的是,Gemma 在关键基准测试中甚至超越了更大模型,同时严格遵守谷歌提出的安全与负责任输出标准。关于 Gemma 性能、数据集构成以及建模方法等细节信息,谷歌还专门发布了一份技术报告:https://storage.googleapis.com/deepmind-media/gemma/gemma-report.pdf。

Gemma 在设计之初就以谷歌的 AI 原则为核心。为了确保 Gemma 预训练模型安全可靠,谷歌采用自动化技术从训练集中筛除掉了某些个人信息及其他敏感数据。此外,谷歌还利用人类反馈(RLHF)对模型进行广泛微调与强化学习,确保指令微调模型始终遵循负责任的行为准则。为了了解并降低 Gemma 模型的风险状况,谷歌还开展了稳健性评估,包括手动红队演练、自动对抗测试以及危险活动模型能力评估等。

谷歌还随 Gemma 模型一道发布新的 Responsible Generative AI Toolkit 负责任生成式 AI 套件,旨在帮助开发人员和研究群体优先构建起安全且负责任的 AI 应用程序。这套工具包中包括:

安全分类:谷歌提供一种新颖方法,能够以最少的示例构建起强大的安全分类器。

调试:模型调试工具,可帮助用户调查 Gemma 的行为并解决潜在问题。

指引:用户可以根据谷歌在开发和部署大语言模型方面的经验,获取模型构建方面的最佳实践。

开放模型正成为主流

虽然谷歌一直强调这些模型的开放属性,但需要注意的是,它们并不属于开源成果。实际上,在之前的新闻发布会上,谷歌公司的 Jeanine Banks 在强调搜索巨头对于开源的承诺之余,曾专门指出谷歌对于 Gemma 模型的开源态度十分谨慎。

Banks 解释称,“开放模型如今在行业内已经相当普遍,而且所指的通常是开放权重模型。也就是说,开发人员和研究人员可以广泛使用这些模型,对模型进行定制和微调;但与此同时,使用条款对于重新分发及所开发变体的所有权问题,往往须根据模型自身的特定情况而有所差异。因此,我们认为开放模型与传统意义上的开源模型及开源代码存在一定区别,将 Gemma 模型称为开放模型可能最为贴切。”

也就是说,开发人员可以使用该模型进行推理、也可随意对模型进行微调。谷歌团队还认为,这样规模的模型在多种场景下都非常适用。

谷歌 DeepMind 产品管理总监 Tris Warkentin 表示,“过去一年以来,生成式 AI 的质量迎来了大幅提升。以往需要超大模型才能完成的工作,如今已经可以在最先进的小型模型上实现。这无疑开发了 AI 应用开发的全新方向,我们对此深感兴奋。如今,我们甚至可以在本地开发者台式机或笔记本电脑上使用 RTX GPU,或者在 Google Cloud Platform 上的单一主机中利用云 TPU 运行大模型推理和微调。”

谷歌在这一领域的其他竞争对手也纷纷入场,拿出自己的开放模型。年轻的 Gemma 家族能不能在对抗中胜出,恐怕只有时间能给出答案。

参考链接:

https://blog.google/technology/developers/gemma-open-models/

https://techcrunch.com/2024/02/21/google-launches-two-new-open-llms/